2025年AI的发展非常迅速,在AI创作领域已经从玩具变成了真正的生产力工具。尤其是最近开源的Z-Image模型,用相对较小的参数量实现了极高的图像生成质量。而且它通过集成Qwen语言模型,支持中英文自然语言来控制画面,再也不用像sd那样一个个英文单词蹦了。

今天给大家带来本地部署Z-Image的详细教程。我的显卡是4070ti super,所以这篇教程也是基于N卡的。

准备工作:下载ComfyUI和模型文件

安装ComfyUI

ComfyUI是目前AI生成领域最牛的框架了,它把AI生图的流程变成了一个个节点,可以像搭乐高积木那样生成工作流。我们可以直接从它的官方GitHub上下载(https://github.com/comfyanonymous/ComfyUI/releases),推荐安装带cuda的版本ComfyUI_windows_portable_nvidia_cu128.7z

下载后解压到一个本地文件夹。找到里面的models文件夹,放入下面下载的模型。

下载Z-Image模型文件

我们可以从魔搭社区直接下载ComfyUI官方提供的z_image_turbo模型(z_image_turbo · 模型库),这是国内版的huggingface,下载可以达到满速

我们需要下载三个文件:

| 类型 | 文件名 | 下载链接 | 放入ComfyUI位置 |

| 生图模型 | z_image_turbo_bf16.safetensors | https://www.modelscope.cn/models/Comfy-Org/z_image_turbo/resolve/master/split_files/diffusion_models/z_image_turbo_bf16.safetensors | ComfyUI\models\diffusion_models\ |

| 文本编码模型 | qwen_3_4b.safetensors | https://www.modelscope.cn/models/Comfy-Org/z_image_turbo/resolve/master/split_files/text_encoders/qwen_3_4b.safetensors | ComfyUI\models\text_encoders\ |

| VAE | ae.safetensors | https://www.modelscope.cn/models/Comfy-Org/z_image_turbo/resolve/master/split_files/vae/ae.safetensors | ComfyUI\models\vae\ |

模型文件放入后,打开ComfyUI_windows_portable根目录下的run_nvidia_gpu.bat运行

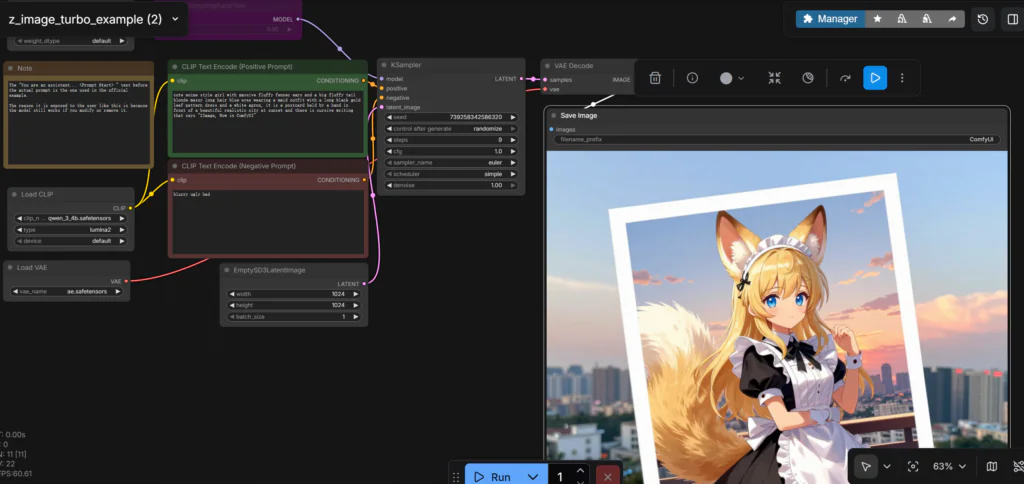

创建Z-Image workflow

从z_image_turbo · 模型库 点击 Z Image | ComfyUI_examples 可以跳转到示例的工作流。这是一张图片,把它直接拖到ComfyUI的界面就可以。

或者可以直接下载这个json拖进ComfyUI的界面:https://pan.quark.cn/s/6115e60feaa7

就可以直接跑了

使用GGUF模型

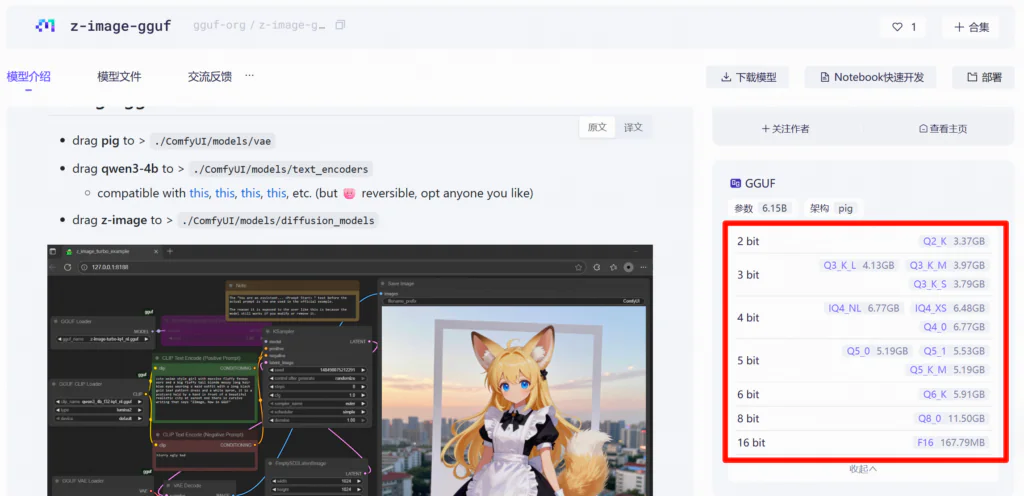

如果你的显存不够16G,可以尝试GGUF的量化模型,这些模型占用显存更小。

在魔搭社区直接搜z-image-gguf,可以找到z-image-gguf · 模型库 可以根据你的显存大小下载对应的量化版本:

下载后放到ComfyUI\models\diffusion_models 目录。

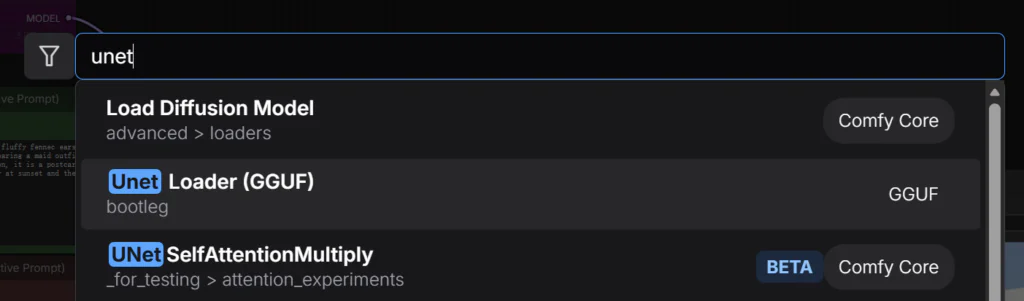

使用GGUF模型,需要在ComfyUI里下载对应的拓展

首先安装ComfyUI manager,这个可以方便安装第三方扩展。安装方式参考ComfyUI-Manager Installation – ComfyUI: 下载 install-manager-for-portable-version.bat 放到 ComfyUI_windows_portable 根目录,然后执行。(需要安装Git)

接下来在Manager -> Custom Nodes Manager里搜索安装ComfyUI-GGUF

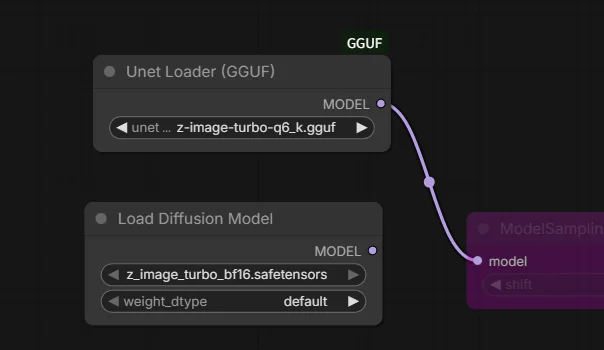

之后双击空白处,添加 Unet Loader(GGUF)节点 ,替换掉原来的Load Diffusion Model节点就可以了

如果大家遇到网络问题,可以下载我下载好的源文件,关注公众号“雅乐网”对话框回复zimage,即可自动回复下载链接。谢谢支持!

支付宝打赏

支付宝打赏  微信打赏

微信打赏